Edge AI бросает вызов технологии памяти

С развитием ИИ на периферии возникает целый ряд новых требований к системам памяти. Могут ли сегодняшние технологии памяти соответствовать строгим требованиям этого нового сложного приложения, и что новые технологии памяти обещают периферийному ИИ в долгосрочной перспективе?

Первое, что нужно понять, это то, что не существует стандартного приложения «граничного ИИ»; край в его самой широкой интерпретации охватывает все электронные системы с поддержкой искусственного интеллекта за пределами облака. Это может включать «ближний край», который обычно охватывает корпоративные центры обработки данных и локальные серверы.

Далее идут такие приложения, как компьютерное зрение для автономного вождения. Оборудование шлюза для производства выполняет логический вывод ИИ для проверки продуктов на производственной линии на предмет дефектов. «Пограничные блоки» 5G на опорах инженерных сетей анализируют видеопотоки для приложений умного города, таких как управление дорожным движением. А инфраструктура 5G использует искусственный интеллект на периферии для сложных, но эффективных алгоритмов формирования луча.

На «дальнем краю» ИИ поддерживается в таких устройствах, как мобильные телефоны - подумайте о фильтрах Snapchat - голосовое управление устройствами и узлами датчиков IoT на фабриках, выполняющих объединение датчиков перед отправкой результатов на другое шлюзовое устройство.

Роль памяти в периферийных системах ИИ - для хранения весов нейронных сетей, кода модели, входных данных и промежуточных активаций - одинакова для большинства приложений ИИ. Рабочие нагрузки необходимо ускорять, чтобы максимизировать вычислительные мощности ИИ, чтобы оставаться эффективными, поэтому требования к емкости и пропускной способности обычно высоки. Однако требования к конкретным приложениям многочисленны и разнообразны и могут включать в себя размер, энергопотребление, работу при низком напряжении, надежность, тепловые / охлаждающие аспекты и стоимость.

Пограничные центры обработки данных

Периферийные центры обработки данных - это ключевой пограничный рынок. Варианты использования варьируются от медицинских изображений, исследований и сложных финансовых алгоритмов, где конфиденциальность предотвращает загрузку в облако. Другой - это беспилотные автомобили, где этому препятствует задержка.

Эти системы используют ту же память, что и серверы других приложений.

«Важно использовать DRAM с малой задержкой для быстрой оперативной памяти на уровне байтов в приложениях, где разрабатываются и обучаются алгоритмы ИИ», - сказал Пекон Гупта, архитектор решений в Smart Modular Technologies, разработчике и разработчике продуктов памяти. «Модули RDIMM высокой емкости или LRDIMM необходимы для больших наборов данных. Модули NVDIMM необходимы для ускорения работы системы - мы используем их для кэширования записи и создания контрольных точек вместо более медленных твердотельных накопителей ».

Пекон Гупта

Размещение вычислительных узлов рядом с конечными пользователями - это подход, используемый операторами связи.

«Мы наблюдаем тенденцию к тому, чтобы эти пограничные [телекоммуникационные] серверы могли выполнять сложные алгоритмы», - сказал Гупта. Следовательно, «поставщики услуг добавляют больше памяти и вычислительной мощности к этим пограничным серверам, используя такие устройства, как RDIMM, LRDIMM и высокодоступную постоянную память, такую как NVDIMM».

Гупта рассматривает Intel Optane, энергонезависимую память компании 3D-Xpoint, свойства которой находятся между DRAM и Flash, как хорошее решение для серверных приложений AI.

«И Optane DIMM, и NVDIMM используются в качестве ускорителей искусственного интеллекта», - сказал он. «Модули NVDIMM обеспечивают многоуровневое хранение с очень низкой задержкой, кэширование, буферизацию записи и возможности хранения метаданных для ускорения приложений ИИ. Модули DIMM для центров обработки данных Optane используются для ускорения работы базы данных в памяти, где от сотен гигабайт до терабайт постоянной памяти используются в сочетании с DRAM. Хотя это оба решения с постоянной памятью для приложений ускорения AI / ML, у них разные и отдельные сценарии использования ».

Кристи Манн, директор по маркетингу продукции компании Intel в Optane, рассказала EE Times Optane получает все больше приложений в сегменте серверного ИИ.

Кристи Манн из Intel

«Наши клиенты уже сегодня используют постоянную память Optane для работы своих приложений искусственного интеллекта», - сказала она. «Они успешно используются для электронной коммерции, систем видеорекламы и финансового анализа в реальном времени. Мы наблюдаем переход к приложениям в памяти из-за увеличения доступной емкости ».

Высокие цены на DRAM делают Optane все более привлекательной альтернативой. Сервер с двумя процессорами Intel Xeon Scalable и постоянной памятью Optane может вместить до 6 терабайт памяти для приложений, требовательных к данным.

«DRAM по-прежнему остается самой популярной, но у нее есть ограничения с точки зрения стоимости и емкости», - сказал Манн. «Новые технологии памяти и хранения, такие как постоянная память Optane и Optane SSD, [появляются] в качестве альтернативы DRAM из-за их стоимости, емкости и преимущества в производительности. Твердотельные накопители Optane особенно эффективны для кэширования данных на жестких дисках и твердотельных накопителях NAND для непрерывной передачи данных приложений искусственного интеллекта ».

Она также добавила, что Optane выгодно отличается от других новых воспоминаний, которые сегодня еще не полностью созрели или масштабируемы.

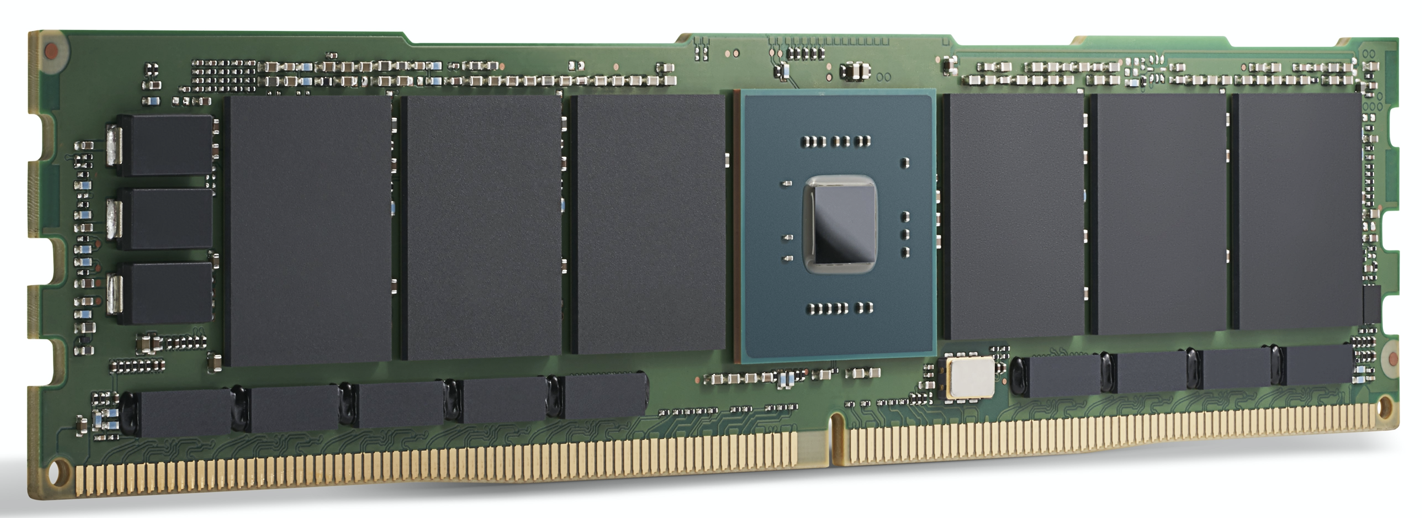

Модуль Intel Optane 200 Series. Intel заявляет, что Optane

уже сегодня используется для поддержки приложений искусственного интеллекта. (Источник:Intel)

Ускорение графического процессора

Для высокотехнологичных периферийных центров обработки данных и пограничных серверов все большую популярность получают ускорители вычислений AI, такие как графические процессоры. Помимо DRAM, здесь можно выбрать память GDDR, специальную память DDR SDRAM, предназначенную для высокопроизводительных графических процессоров, и HBM, относительно новую технологию наложения кристаллов, при которой несколько кристаллов памяти размещаются в том же корпусе, что и сам графический процессор.

Оба предназначены для чрезвычайно высокой пропускной способности памяти, необходимой для приложений искусственного интеллекта.

Для наиболее требовательного обучения модели искусственного интеллекта HBM2E предлагает 3,6 Гбит / с и обеспечивает пропускную способность памяти 460 ГБ / с (два стека HBM2E обеспечивают скорость около 1 ТБ / с). Это одна из самых высокопроизводительных доступных модулей памяти на минимальной площади с минимальным энергопотреблением. HBM используется Nvidia, лидером в области графических процессоров, во всех продуктах для центров обработки данных.

«GDDR6 также используется для приложений логического вывода ИИ на периферии», - сказал Фрэнк Ферро, старший директор по маркетингу продуктов IP-ядер в Rambus. Ферро сказал, что GDDR6 может удовлетворить требования к скорости, стоимости и мощности периферийных систем логического вывода ИИ. Например, GDDR6 может передавать 18 Гбит / с и обеспечивает 72 ГБ / с. Наличие четырех модулей DRAM GDDR6 обеспечивает пропускную способность памяти около 300 ГБ / с.

«GDDR6 используется для логического вывода ИИ и приложений ADAS, - добавил Ферро.

При сравнении GDDR6 с LPDDR, подходом Nvidia к большинству периферийных решений, не связанных с центрами обработки данных, от Jetson AGX Xavier до Jetson Nano, Ферро признал, что LPDDR подходит для недорогого вывода ИИ на границе или конечной точке.

«Пропускная способность LPDDR ограничена 4,2 Гбит / с для LPDDR4 и 6,4 Гбит / с для LPDDR5», - сказал он. «По мере роста требований к пропускной способности памяти мы увидим все большее количество проектов, использующих GDDR6. Этот разрыв в полосе пропускания памяти помогает стимулировать спрос на GDDR6 ».

Фрэнк Ферро из Рамбуса

Несмотря на то, что они предназначены для использования вместе с графическими процессорами, другие ускорители обработки могут использовать пропускную способность GDDR. Ферро особо выделил Achronix Speedster7t, ускоритель искусственного интеллекта на базе FPGA, используемый для логических выводов и некоторого низкоуровневого обучения.

«В периферийных приложениях искусственного интеллекта есть место как для памяти HBM, так и для GDDR, - сказал Ферро. HBM «по-прежнему будет использоваться в периферийных приложениях. Несмотря на все преимущества HBM, стоимость остается высокой из-за 3D-технологии и производства 2.5D. Учитывая это, GDDR6 представляет собой хороший компромисс между стоимостью и производительностью, особенно для AI Inference в сети ».

HBM используется в высокопроизводительных ИИ ASIC центров обработки данных, таких как Graphcore IPU. Несмотря на то, что он предлагает отличную производительность, его цена может быть высокой для некоторых приложений.

Qualcomm - одна из тех, кто использует этот подход. Его Cloud AI 100 нацелен на ускорение вывода ИИ в периферийных центрах обработки данных, «периферийные блоки» 5G, ADAS / автономное вождение и инфраструктуру 5G.

«Для нас было важно использовать стандартную память DRAM, а не что-то вроде HBM, потому что мы хотим сократить расходы на материалы», - сказал Кейт Крессин, генеральный менеджер подразделения Qualcomm Computing and Edge Cloud. «Мы хотели использовать стандартные компоненты, которые можно купить у нескольких поставщиков. У нас есть клиенты, которые хотят делать все на чипе, и у нас есть клиенты, которые хотят использовать кросс-карты. Но все они хотели сохранить разумную стоимость и не покупать HBM или даже более экзотические модули памяти.

«Во время обучения, - продолжил он, - у вас есть действительно большие модели, которые будут работать на [несколько микросхем], но для вывода [рынок Cloud AI 100] многие модели более локализованы».

Дальний край

За пределами центра обработки данных периферийные системы искусственного интеллекта обычно ориентированы на логический вывод, за некоторыми заметными исключениями, такими как федеративное обучение и другие методы инкрементного обучения.

Некоторые ускорители ИИ для приложений, чувствительных к энергопотреблению, используют память для обработки ИИ. Вывод, основанный на умножении многомерных матриц, поддается аналоговым вычислительным методам с массивом ячеек памяти, используемых для выполнения вычислений. Используя эту технику, устройства Syntiant предназначены для голосового управления бытовой электроникой, а устройства Gyrfalcon были разработаны в смартфоне, где они обрабатывают логический вывод для эффектов камеры.

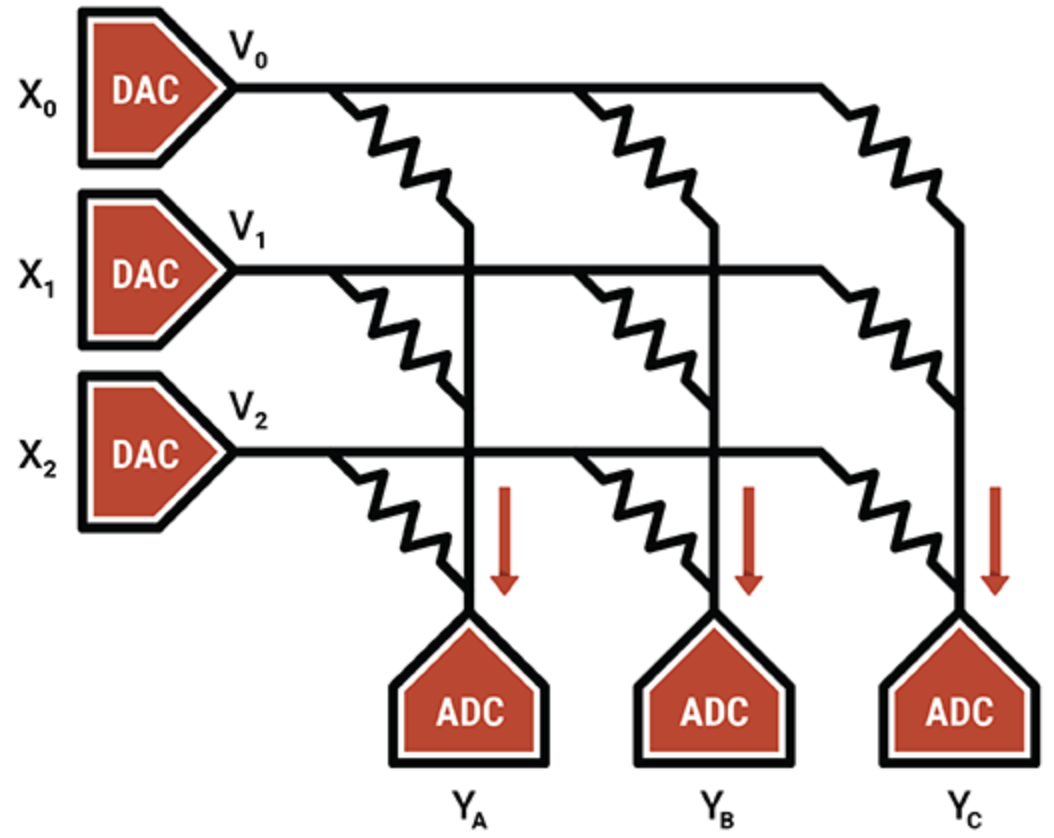

В другом примере компания Mythic, специализирующаяся на интеллектуальных процессорах, использует аналоговую операцию ячеек флэш-памяти для хранения 8-битного целого числа (один весовой параметр) на одном флэш-транзисторе, что делает его намного более плотным, чем другие технологии вычислений в памяти. Запрограммированный импульсный транзистор работает как переменный резистор; входы подаются как напряжения, а выходы - как токи. В сочетании с АЦП и ЦАП в результате получается эффективный механизм матричного умножения.

IP Mythic заключается в методах компенсации и калибровки, которые устраняют шум и обеспечивают надежные 8-битные вычисления.

Mythic использует массив транзисторов флэш-памяти для создания плотных механизмов умножения-накопления (Источник:Mythic)

Помимо устройств с вычислением в памяти, ASIC популярны для определенных периферийных ниш, особенно для систем с низким и сверхнизким энергопотреблением. Системы памяти для ASIC используют комбинацию нескольких типов памяти. Распределенная локальная SRAM - самая быстрая, наиболее энергоэффективная, но не очень эффективная по площади. Наличие одной большой SRAM на кристалле более эффективно по площади, но создает узкие места для производительности. Внешняя память DRAM дешевле, но потребляет гораздо больше энергии.

Джефф Тейт, генеральный директор Flex Logix, сказал, что для поиска правильного баланса между распределенной SRAM, объемной SRAM и внешней памятью DRAM для InferX X1 потребовался ряд моделирования производительности. Цель заключалась в том, чтобы максимизировать пропускную способность вывода на доллар - функцию размера кристалла, стоимости пакета и количества используемых DRAM.

«Оптимальной точкой была одна память x32 LPDDR4 DRAM; 4K MAC (7,5 TOPS при 933 МГц); и около 10 МБ SRAM », - сказал он. «SRAM работает быстро, но дорого по сравнению с DRAM. Используя 16-нм техпроцесс TSMC, 1 МБ SRAM занимает около 1,1 мм 2 . «Наш InferX X1 имеет толщину всего 54 мм 2 . и из-за нашей архитектуры доступ к DRAM в значительной степени перекрывается с вычислениями, поэтому производительность отсутствует. Для больших моделей наличие единственной DRAM - правильный компромисс, по крайней мере, с нашей архитектурой », - сказал Тейт.

Микросхема Flex Logix будет использоваться в пограничных приложениях вывода ИИ, требующих работы в реальном времени, включая анализ потокового видео с низкой задержкой. Сюда входят системы ADAS, анализ видеозаписей с камер видеонаблюдения, медицинские изображения и приложения для обеспечения / проверки качества.

Какой тип DRAM будет использоваться вместе с InferX X1 в этих приложениях?

«Мы думаем, что LPDDR будет самой популярной:одна DRAM дает пропускную способность более 10 ГБ / сек… но при этом имеет достаточно бит для хранения весовых коэффициентов / промежуточных активаций», - сказал Тейт. «Для любой другой DRAM потребуется больше микросхем и интерфейсов, и нужно будет покупать больше битов, которые не используются».

Есть ли здесь место для каких-либо новых технологий памяти?

«Стоимость пластины резко возрастает при использовании любой новой памяти, в то время как SRAM« бесплатна », за исключением области кремния», - добавил он. «По мере изменения экономики переломный момент тоже может измениться, но он будет еще дальше».

Новые воспоминания

Несмотря на экономичность масштаба, другие типы памяти открывают будущие возможности для приложений ИИ.

MRAM (магниторезистивное ОЗУ) хранит каждый бит данных посредством ориентации магнитов, контролируемой приложенным электрическим напряжением. Если напряжение ниже, чем требуется для переключения бита, существует только вероятность того, что бит переключится. Эта случайность нежелательна, поэтому MRAM приводится в действие более высоким напряжением, чтобы предотвратить ее. Тем не менее, некоторые приложения ИИ могут использовать эту врожденную стохастичность (которую можно рассматривать как процесс случайного выбора или генерации данных).

Эксперименты применили возможности стохастичности MRAM к устройствам Gyrfalcon, метод, посредством которого точность всех весов и активаций снижается до 1 бита. Это используется для значительного снижения требований к вычислительным ресурсам и мощности для удаленных приложений. Возможны компромиссы с точностью, в зависимости от того, как сеть переобучается. В целом нейронные сети можно заставить работать надежно, несмотря на пониженную точность.

«Бинаризованные нейронные сети уникальны тем, что они могут надежно функционировать, даже если достоверность числа, равного -1 или +1, снижена», - сказал Энди Уокер, вице-президент по продуктам Spin Memory. «Мы обнаружили, что такие BNN могут по-прежнему функционировать с высоким уровнем точности, поскольку эта уверенность снижается [путем] введения так называемого« коэффициента битовых ошибок »для битов памяти, записываемых неправильно».

Энди Уокер из Spin Memory

MRAM, естественно, может создавать частоту ошибок по битам управляемым образом при низких уровнях напряжения, поддерживая точность и еще больше снижая требования к мощности. Ключевым моментом является определение оптимальной точности при минимальном напряжении и кратчайшем времени. По словам Уолкера, это означает высочайшую энергоэффективность.

Хотя этот метод также применим к нейронным сетям с более высокой точностью, он особенно подходит для BNN, поскольку ячейка MRAM имеет два состояния, которые соответствуют двоичным состояниям в BNN.

По словам Уокера, использование MRAM на периферии - еще одно потенциальное применение.

«Для периферийного ИИ MRAM может работать при более низких напряжениях в приложениях, где высокая точность не является требованием, но очень важны улучшения в энергоэффективности и долговечности памяти», - сказал он. «Кроме того, присущая MRAM энергонезависимость позволяет сохранять данные без питания.

Одно из приложений - это так называемая унифицированная память, «где эта новая память может выступать в качестве как встроенной флэш-памяти, так и замены SRAM, экономя площадь на кристалле и избегая статического рассеивания мощности, присущего SRAM».

Хотя MRAM Spin Memory находится на грани коммерческого внедрения, конкретная реализация BNN лучше всего подойдет для варианта базовой ячейки MRAM. Следовательно, он остается на стадии исследования.

Нейроморфный ReRAM

Еще одна новая память для периферийных приложений ИИ - это ReRAM. Недавнее исследование Миланского политехнического университета с использованием технологии ReRAM из оксида кремния Weebit Nano (SiOx) показало многообещающие перспективы для нейроморфных вычислений. ReRAM добавил пластичности аппаратному обеспечению нейронных сетей; то есть он может развиваться по мере изменения условий - полезное качество в нейроморфных вычислениях.

Современные нейронные сети не могут учиться, не забывая о задачах, которым они были обучены, в то время как мозг может делать это довольно легко. С точки зрения искусственного интеллекта, это «обучение без учителя», когда алгоритм выполняет логический вывод на наборах данных без меток, ища свои собственные шаблоны в данных. Конечным результатом могут быть периферийные системы искусственного интеллекта с поддержкой ReRAM, которые могут изучать новые задачи на месте и адаптироваться к окружающей среде.

В целом производители памяти внедряют технологии, обеспечивающие скорость и пропускную способность, необходимые для приложений искусственного интеллекта. Различная память, будь то на том же чипе, что и вычислитель ИИ, в одном пакете или в отдельных модулях, доступна для многих периферийных приложений ИИ.

Хотя точный характер систем памяти для периферийного ИИ зависит от приложения, GDDR, HBM и Optane становятся популярными для центров обработки данных, в то время как LPDDR конкурирует со встроенной SRAM для приложений конечных точек.

Новые воспоминания придают свои новые свойства исследованиям, направленным на продвижение нейронных сетей за пределы возможностей современного оборудования, чтобы сделать будущие энергоэффективные системы, вдохновленные мозгом.

>> Эта статья была первоначально опубликована на наш дочерний сайт EE Times.

Встроенный

- Постоянная память (ПЗУ)

- Микропроцессоры

- Большие данные, непросто:преодоление новых проблем в технологии технического обслуживания предприятий

- Встроенная память для выборки ST с изменением фазы для автомобильных микроконтроллеров

- Технология граничных приложений приносит пользу всем отраслям

- 5G и Edge поднимают новые задачи кибербезопасности на 2021 год

- 4 совета и проблемы по улучшению управления активами IIoT

- 3 ярких примера передовых передовых производственных технологий

- Технология линейного перемещения

- Как подключенные технологии могут помочь решить проблемы цепочки поставок