Устранение предвзятости обучения в машинном обучении

Научить кого-либо «справедливости» - похвальная цель.

Как люди, мы не всегда можем договариваться о том, что справедливо. Иногда это зависит от контекста. Приучать детей быть справедливыми - как дома, так и в школе - фундаментально, но это легче сказать, чем сделать. Имея это в виду, как мы, как общество, можем сообщить о нюансах «справедливости» системам искусственного интеллекта (ИИ)?

Команда исследователей из IBM Research решает эту загадку первыми. IBM выпускает набор инструментов для разработчиков под названием «AI Fairness 360». В рамках этих усилий IBM предлагает предприятиям новую «облачную службу обнаружения предвзятости и смягчения последствий», которую корпорации могут использовать для тестирования и проверки поведения систем, управляемых ИИ.

В телефонном интервью EE Times Саска Мойсилович, научный сотрудник IBM Research, сказал нам, что ученые и практики ИИ слишком сосредоточены на точности ИИ. Обычно первый вопрос, который люди задают об ИИ:«Могут ли машины победить людей?»

Но как насчет справедливости? По ее словам, отсутствие справедливости в искусственном интеллекте может вызвать катастрофические последствия, например, для здравоохранения или автономных транспортных средств.

Что делать, если набор данных, используемый для обучения машины, является необъективным? Если ИИ не может объяснить, как он пришел к решению, как мы можем проверить его «правильность»? Может ли ИИ выявить, были ли данные каким-либо образом изменены во время обработки ИИ? Может ли ИИ заверить нас, что его данные никогда не подвергались атакам или компрометации, в том числе во время предварительной и постобработки?

Короче говоря, существует ли такая вещь, как интроспективный ИИ? Простой ответ:нет.

«Без прозрачности для пользователей, разработчиков и практиков ИИ системы ИИ не могут завоевать доверие общества», - сказал Мойсилович.

Разборка справедливости

Более важный вопрос - как научить машину тому, что такое справедливость. Мойсилович отметил:«Поскольку мы ученые, первое, что мы сделали, это разложили на части« справедливость ». Нам нужно было взяться за это дело». Они нарушили справедливость с точки зрения показателей, алгоритмов и предвзятости, практикуемой при реализации ИИ.

Куш Варшней, научный сотрудник IBM, объяснил, что команда исследовала предвзятость и справедливость в алгоритмах ИИ и принятии решений ИИ. «Есть справедливость по отношению к отдельным людям и справедливость по отношению к группам. Мы рассмотрели разные атрибуты групп - от пола до расы. Также рассматриваются правовые и нормативные вопросы ». В итоге команда измерила 30 различных показателей, чтобы выявить предвзятость в наборах данных, моделях ИИ и алгоритмах.

Эти результаты включены в набор инструментов AI Fairness 360, выпущенный IBM на этой неделе. Компания описала его как «комплексный набор метрик с открытым исходным кодом для проверки на предмет нежелательной предвзятости в наборах данных и моделях машинного обучения».

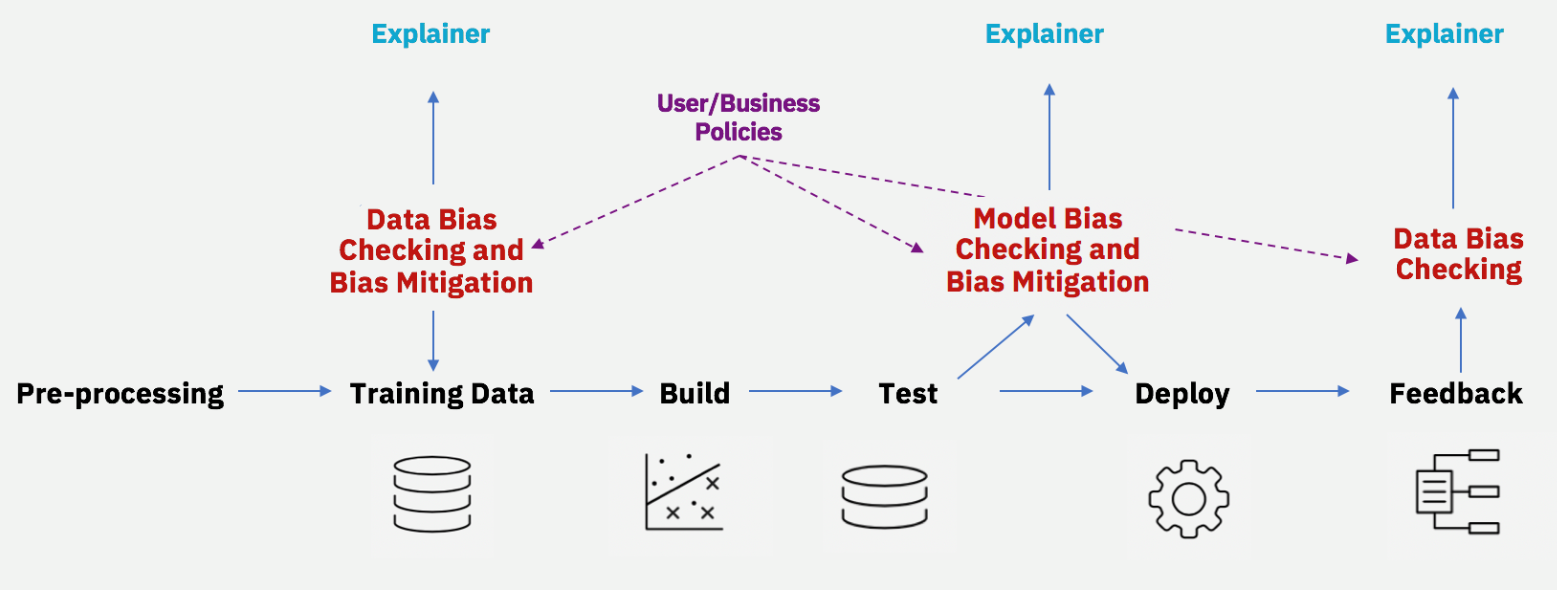

Снижение предвзятости на протяжении всего жизненного цикла ИИ (Источник:IBM)

Хотя многие ученые уже работают над выявлением дискриминации в алгоритмах ИИ, Мойсилович сказал, что подход IBM отличается тем, что включает алгоритмы не только для поиска смещения, но и инструмента для устранения смещения.

На базовом уровне вы должны спросить:компьютерщики - определение справедливости? Это задача, которую обычно поручают социологам? Осознавая это несоответствие, IBM дала понять, что ни Мойсилович, ни Варшней не работают в вакууме. Они привлекли множество ученых и институтов. Варшни участвовал в конференции по этике Уэхиро-Карнеги-Оксфорд, организованной Советом Карнеги по этике в международных делах. Мойсилович участвовал в семинаре по искусственному интеллекту в Беркли, штат Калифорния, спонсором которого выступила Юридическая школа Калифорнийского университета в Беркли.

Является ли алгоритм нейтральным?

Социологи уже давно указывают на проблему предвзятости ИИ.

Юная Ми Ким, профессор Школы журналистики и массовых коммуникаций Университета Висконсин-Мэдисон, пояснила:«Дискриминация ИИ (или предвзятость ИИ) может происходить, когда она неявно или явно усиливает существующие неравные социальные порядки и предубеждения (например, пол, раса, возраст, социальный / экономический статус и т. д.) ». Примеры варьируются от ошибок выборки (например, недостаточное представление определенных демографических данных из-за несоответствующих или трудностей методов выборки) до человеческих предубеждений при машинном обучении (моделирование). Ким утверждала, что предвзятость ИИ существует даже в случае «стратегических решений» в дизайне или моделировании, таких как алгоритмы политической рекламы.

В своем недавнем исследовании под названием «Алгоритмические возможности:цифровая реклама и неравенство политического участия» Ким продемонстрировала, как неравенство может быть усилено с помощью решений, основанных на алгоритмах.

Техническое сообщество может возразить, что «алгоритм нейтрален» или что его можно «обучить» (обучить). Ким отметила:«Это не означает, что предубеждения возникают на любом этапе разработки алгоритма».

Интернет вещей

- Машинное обучение на AWS; Знай все

- Цепочка поставок и машинное обучение

- Повышение эффективности обучения надежности

- Mobius представляет программное обеспечение для обучения балансировке машин

- NXP удваивает объем машинного обучения на периферии

- Как использовать машинное обучение в сегодняшней корпоративной среде

- Машинное обучение в полевых условиях

- Преодоление кривой обучения PID

- Машинное обучение в профилактическом обслуживании

- Прогнозирование срока службы батареи с помощью машинного обучения